Segment Anything Model (SAM) je vrhunski AI model koji može da precizno i efikasno izdvoji objekte na slikama

Kompanija Meta objavila je novi AI model Segment Anything Model (SAM), koji može da izdvoji pojedinačne objekte unutar slike, zajedno sa skupom podataka napomena na slikama.

Segmentacija slike je osnovni zadatak u kompjuterskom vidu koji ima za cilj da podijeli sliku na regije koje odgovaraju različitim objektima ili semantičkim kategorijama i ima mnogo aplikacija, kao što su otkrivanje objekata, razumijevanje scene, uređivanje slike i analiza videa.

Međutim, segmentacija slike je takođe izazovan problem, posebno kada se radi o složenim scenama koje sadrže više objekata različitih oblika, veličina i izgleda. Štaviše, većina postojećih metoda segmentacije slike zahtjeva velike količine podataka sa komentarima za obuku, čije dobijanje može biti skupo i dugotrajno. Meta želi da riješi ovaj problem sa SAM modelom.

Šta je Metin novi Segment Anything Model?

Segment Anything Model (SAM) je novi i moćan model vještačke inteligencije koji može da segmentuje bilo koji objekt na slici ili videu uz visoki kvalitet i efikasnost.

Today we're releasing the Segment Anything Model (SAM) — a step toward the first foundation model for image segmentation.

SAM is capable of one-click segmentation of any object from any photo or video + zero-shot transfer to other segmentation tasks ➡️ https://t.co/qYUoePrWVi pic.twitter.com/zX4Rxb5Yfo

— AI at Meta (@AIatMeta) April 5, 2023

Segmentacija je proces odvajanja objekta od njegove pozadine ili drugih objekata i stvaranja maske koja ocrtava njegov oblik i granice. Sa SAM modelom, vaši zadaci uređivanja, sastavljanja, praćenja, prepoznavanja i analize će postati lakši.

SAM se razlikuje od ostalih modela segmentacije na nekoliko načina, kao što su:

- SAM je promptabilan, što znači da može da uzme različite upite za unos, kao što su tačke ili okviri, da specifikuje koji objekt treba da segmentuje. Na primjer, možete da nacrtate okvir oko lica osobe, a model Segment Anything će generisati masku za lice. Takođe možete dati višestruke upite za segmentovanje više objekata odjednom. SAM model može da upravlja složenim scenama sa okluzijama, refleksijama i sjenama.

- SAM je obučen na ogromnom skupu podataka od 11 miliona slika i 1,1 milijardu maski, što je najveći skup podataka segmentacije do sada. Ovaj skup podataka pokriva širok spektar objekata i kategorija, kao što su životinje, biljke, vozila, namještaj, hrana i još mnogo toga. SAM može da segmentuje objekte koje nikada prije nije vidio, zahvaljujući svojoj sposobnosti generalizacije i raznolikosti podataka.

- SAM ima snažne performanse „zero-shot“ na različitim zadacima segmentacije. „Zero-shot“ znači da SAM može da segmentuje objekte bez dodatne obuke ili finog podešavanja na određenom zadatku ili domenu. Na primjer, SAM može da segmentuje lica, ruke, kosu, odjeću i dodatke bez prethodnog znanja ili nadzora. SAM takođe može segmentovati objekte u različitim modalitetima, kao što su infracrvene slike ili mape dubine.

SAM model postiže impresivne rezultate na različitim mjerilima segmentacije slike, kao što je COCO.

Metin model nadmašuje ili odgovara prethodnim potpuno nadgledanim metodama na nekoliko zadataka segmentacije nulte tačke, kao što je segmentovanje logotipa, teksta, lica ili skica. Pokazuje svoju svestranost i robusnost u različitim domenima i scenarijima.

Biranje objekata klikom na njih

Istraživački odsjek kompanije je saopštio da bi njen model Segment Anything Model (SAM), mogao da identifikuje objekte na slikama i video snimcima, čak i u slučajevima kada nije naišao na te stavke u svojoj obuci.

Koristeći SAM, objekti mogu da se biraju klikom na njih ili pisanjem tekstualnih upita.

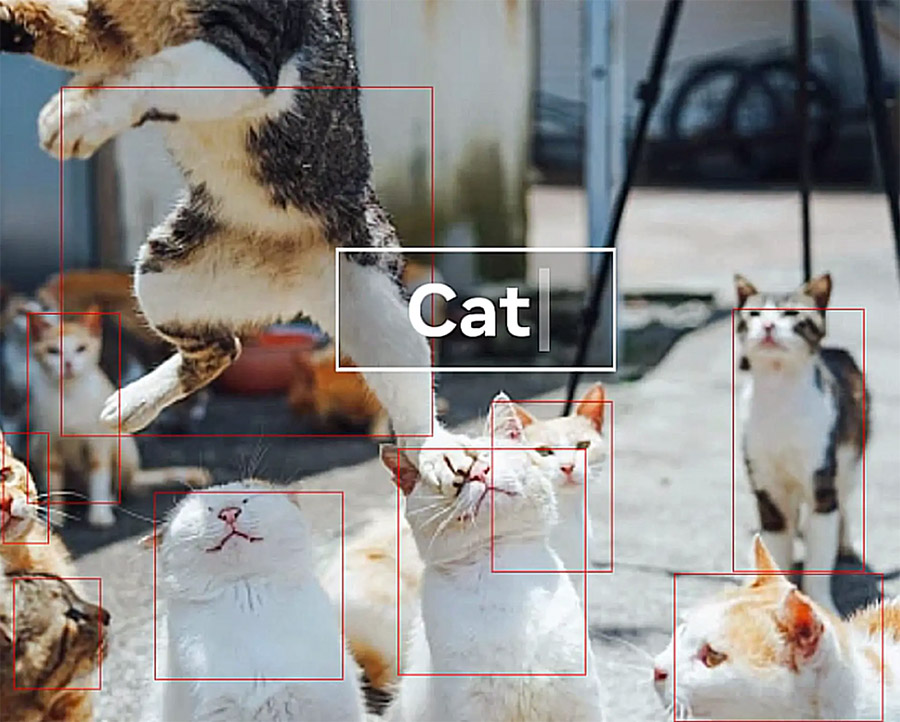

Navodi se jedan primjer: pisanje riječi „mačka“ podstaklo je alat da nacrta kutije oko svake od nekoliko mačaka na fotografiji.

Velike tehnološke kompanije govore o svojim otkrićima u oblasti vještačke inteligencije otkako je ChatGPT, četbot OpenAI-a, koji podržava Microsoft, postao senzacija u jesen, izazvavši talas investicija i trku za dominacijom.

Meta je inicirala nekoliko funkcija koje primenjuju tip generativne veštačke inteligencije koju je popularizovao ChatGPT.

Dodaje se da ona stvara potpuno nov sadržaj umjesto da jednostavno identifikuje ili kategoriše podatke kao što to čini drugi AI.

Primjeri uključuju alatku koja kreira nadrealne video snimke iz tekstualnih upita i drugu koja generiše dječiju knjigu proze sa ilustracija.

Kako funkcioniše SAM model?

Jedno od najintrigantnijih otkrića u NLP-u i, odnedavno, u kompjuterskoj viziji je upotreba „podsticajnih“ pristupa kako bi se omogućilo učenje nulte i nekoliko snimaka na novim skupovima podataka i zadacima koristeći temeljne modele. Meta je pronašao motivaciju na ovom polju.

Ako su date tačke prednjeg plana/pozadine, grubi okvir ili maska, tekst slobodnog oblika ili bilo koji drugi unos koji pokazuje šta segmentovati na slici, Meta AI tim je naučio model Segment Anything da generiše odgovarajuću masku za segmentaciju.

Potreba za odgovarajućom maskom samo implicira da bi izlaz trebao biti odgovarajuća maska za jednu od stvari na koje se upit može odnositi (na primjer, tačka na košulji može predstavljati ili košulju ili osobu koja je nosi). Ovaj zadatak se koristi za prethodnu obuku modela i za usmjeravanje rješenja generičkih problema segmentacije nizvodno.

Meta je primijetila da zadatak prije obuke i interaktivno prikupljanje podataka nameću određena ograničenja na konstrukciju modela. Konkretno, njihovi anotatori moraju biti u mogućnosti da koriste Segment Anything Model u pretraživaču, interaktivno, u realnom vremenu, na CPU-u da bi bio efikasan. Uprkos činjenici da mora postojati neki kompromis između kvaliteta i brzine kako bi se ispunili zahtjevi vremena rada, oni otkrivaju da direktan pristup daje zadovoljavajuće rezultate.

Na poleđini, koder slike stvara jedinstveno ugrađivanje slike, dok lagani enkoder može trenutno da transformiše bilo koji upit u vektor za ugrađivanje. Lagani dekoder se zatim koristi za spajanje ova dva izvora podataka kako bi se predvidjele maske segmentacije. Nakon što je ugrađivanje slike izračunato, SAM može da odgovori na svaki upit u web pretraživaču segmentom za oko 50 ms.

Kako koristiti SAM?

SAM je koristan alat za kreativne profesionalce i entuzijaste koji žele da uređuju slike i video zapise s lakoćom i fleksibilnošću. Ali prvo morate da naučite kako da mu pristupite i koristite.

SAM je razvio Meta AI Research (ranije Facebook AI Research), a javno je dostupan na GitHub-u. Takođe možete isprobati SAM na mreži sa demo ili da preuzmete skup podataka (SA-1B) od 1 milijarde maski i 11 miliona slika. Model je prilično jednostavan za korištenje; samo slijedite ove korake:

- Preuzmite demo ili idite na demo Segment Anything Model.

- Otpremite sliku ili je odaberite u galeriji.

- Dodajte i predmetna područja

- Maskirajte područja dodavanjem tačaka. Odaberite Dodaj područje, a zatim odaberite objekt. Pročistite masku odabirom Ukloni područje, a zatim odaberite područje.

- Zatim izvršite svoj zadatak kako želite! Za više informacija kliknite ovdje.

(IT mixer)